CentOS7にSparkの環境を手っ取り早く構築する

-

カテゴリ:

- サーバ

sparkの環境構築手順の走り書きメモです。あくまでメモなので、手っ取り早くSparkを簡単に設定したい時用なことに注意。

環境はCentOS7、Apache2.4で設定しています。

1. Javaのインストール

Open Javaをyumでインストールする

まずはインストール可能なopenjdkを検索

$ yum search openjdk

ランタイムのインストール

$ sudo yum install java-1.8.0-openjdk

開発環境のインストール

$ sudo yum install java-1.8.0-openjdk-devel

2. Apache Sparkのインストール

※「http://ftp.jaist.ac.jp/pub/apache/spark/」で最新盤を確認

ダウンロードする

$ cd /var/tmp

$ wget http://ftp.jaist.ac.jp/pub/apache/spark/spark-2.0.2/spark-2.0.2-bin-hadoop2.7.tgz

→Hadoop 2.7が含まれているバージョンを入れます

解凍する

$ sudo tar zxvf spark-2.0.2-bin-hadoop2.7.tgz -C /usr/local/lib/

シンボリックリンクを作成する

$ ln -s /usr/local/lib/spark-2.0.2-bin-hadoop2.7 /usr/local/lib/spark

環境変数の追加する

$ sudo vi /etc/profile.d/spark.sh

以下の2つの設定を挿入

export SPARK_HOME=/usr/local/lib/spark

export PATH=$SPARK_HOME/bin:$PATH

保存が終わったら再読み込み

$ source /etc/profile

3. 最後に正常にセットアップできたか確認

$ spark-shell --version

4. scalaのインストール(scala入れてない場合)

$ su

$ cd /usr/local/lib

$ sudo wget http://www.scala-lang.org/files/archive/scala-2.12.1.tgz

$ sudo tar -xzvf scala-2.12.1.tgz

$ sudo chown -R a-fujita:a-fujita scala-2.12.1

$ sudo ln -sv scala-2.12.1 scala

環境変数の追加する

$ sudo vi /etc/profile.d/scala.sh

以下の2つの設定を挿入

export SCALA_HOME=/usr/local/lib/scala

export PATH=$SCALA_HOME/bin:$PATH

保存が終わったら再読み込み

$ source /etc/profile

投稿日:2018-11-18

更新日:2019-01-29

[スポンサーリンク]

[スポンサーリンク]

関連記事

サイト内検索

プロフィール

[Name : POCO(@PocoIt2019)]

都内で社内SEをしているおじさん。

仕事で得られる知識だけでは限界を感じ、

WEBの勉強がてらITブログを開始。

サーバからWEBサイトまでフルスクラッチで開発しました。

現在は勉強のモチベーションを保つために活用中。

興味があることを雑記的に書いていきます。

[スポンサーリンク]

カテゴリ

タグ

[スポンサーリンク]

最近の記事

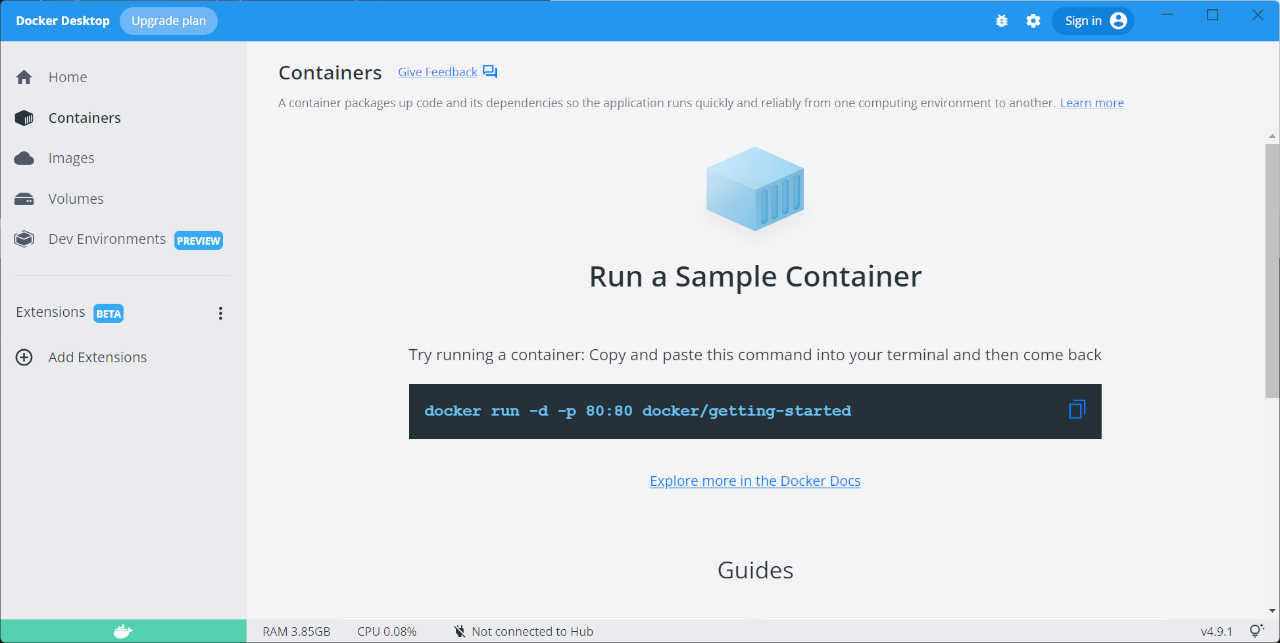

- 「Docker Desktop for Windows」でdocker-compose up中に「user declined directory sharing」のエラーが出た時の対処法

- 【Vue.js】Vue.jsのインストールとプロジェクトの新規作成

- Node.jsをWindows10にインストールする

- 【phpMyAdmin】データインポート時に「スクリプトがタイムアウトしました。インポートを完了させたいのであれば同じファイルを再送信すればインポートが再開されます」が出た時の対処法

- 【phpMyAdmin】ローカル環境でデータインポート時に「Incorrect format parameter」のエラーが出た時の対処法

- 作業効率アップ!Googleドライブをローカルフォルダのように利用する方法